Об этом сообщает «Politexpert» со ссылкой на HackerNoon

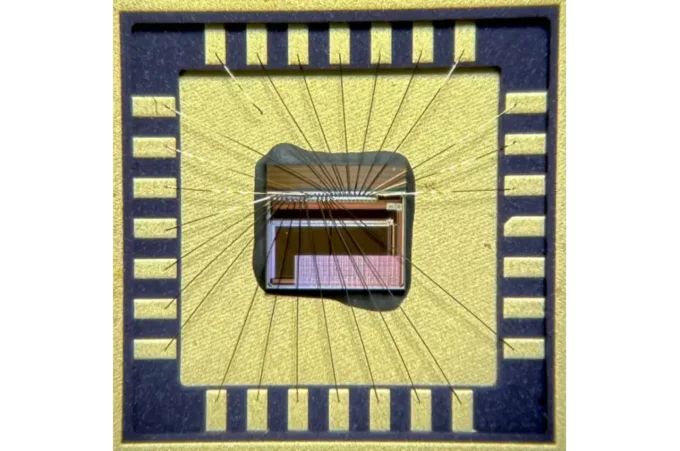

Эффективность обработки больших языковых моделей (LLM) — ключевой вызов в развитии искусственного интеллекта. Одним из направлений улучшения скорости генерации текстов стало параллельное декодирование, но существующие методы часто требуют сложных архитектурных изменений или использования нескольких моделей одновременно. Новая концепция консистентных больших языковых моделей (CLLM) предлагает решение, сохраняя качество генерации и значительно ускоряя процесс.

CLLM позволяет преодолеть ограничения традиционных техник, предоставляя метод, который адаптируется к предобученной модели без дополнительных компонентов. Это снижает сложности внедрения и обеспечивает гибкую интеграцию с другими оптимизационными технологиями, расширяя возможности масштабирования и применения LLM в различных задачах.

Суть технологии и особенности CLLM

Главной инновацией CLLM является применение механизма параллельного декодирования на основе итераций Якоби, которые обеспечивают сходимость генерации текста за несколько шагов. Эта технология минимизирует время вывода, не влияя на качество и полноту получаемого результата. Важным аспектом является обучение модели с использованием консистентных потерь, что способствует одноступенчатому сжатию процесса вывода.

CLLM не требует изменений в базовой архитектуре трансформера и не нуждается в вспомогательных модулях, что делает её удобной для интеграции в уже существующие решения. Кроме того, эта модель совместима с другими подходами ускорения вывода, что открывает возможности для комплексной оптимизации вычислительных ресурсов.

Результаты и сравнительный анализ

Испытания CLLM на различных наборах данных показали значительный прирост скорости генерации — до 3,4 раза по сравнению с традиционными методами. При этом качество создаваемых текстов остаётся на уровне базовых моделей с автогрессивным декодированием, что подтверждается объективными метриками. Такой баланс между производительностью и качеством делает CLLM перспективным инструментом для промышленных и исследовательских применений.

В сравнении с альтернативными подходами, которые требуют дополнительных вычислительных затрат или архитектурных модификаций, CLLM выделяется простотой внедрения и экономией ресурсов. Это важно для компаний и разработчиков, стремящихся к масштабированию решений на основе LLM без серьёзных изменений инфраструктуры.

Текущие ограничения и направления развития

Несмотря на очевидные преимущества, технология CLLM пока не лишена ограничений. В частности, вопросы стабильности работы при обработке очень больших или специализированных текстовых данных остаются предметом дальнейших исследований. Также требуется углублённый анализ взаимодействия с различными типами моделей и способов обучения.

Будущие исследования нацелены на расширение возможностей CLLM, включая разработку новых методов обучения и оптимизации, а также адаптацию под мультизадачные сценарии. Перспектива объединения CLLM с другими эффективными методами ускорения обещает дальнейшее повышение производительности и универсальности.

Значение для индустрии и научного сообщества

Появление CLLM знаменует собой важный шаг в развитии технологий искусственного интеллекта, обеспечивая новые возможности для быстрого и качественного генеративного вывода. Это способствует снижению затрат на вычисления и расширению спектра применения больших языковых моделей в реальном времени. Индустрия получает инструмент, который облегчает внедрение AI в разнообразные сферы, от обработки естественного языка до автоматизации и поддержки принятия решений.

Объединение простоты, скорости и совместимости с существующими технологиями делает CLLM перспективным направлением, привлекающим внимание исследователей и разработчиков по всему миру.

Напомним, ранее мы писали о том, как страна может превратить данные граждан в национальное достояние.